こんにちは、田中啓之(ひろくん)です。今回はAI氣道のライブ配信「ゲストはAI!ChatGPTの声が進化した新ボイスモードを体験しよう」(9月10日放送)をもとに、ChatGPTの最新ボイス機能と、その活用アイデア、実演レポートを徹底的にまとめました。動画はAI氣道さんの配信ですが、私も今回のテーマに深く共感しているので、3方よしAI共創コンサルタント兼おうちCEOという立場から、実務寄りの視点で分かりやすく解説していきますよ。😊

目次

- 🔍 要点まとめ(イントロ)

- 🗣️ ChatGPT Voiceって何が変わったの?

- 🌐 GoogleのAIモード登場と意味するところ

- 📸 実演レポート(キャプチャ付き)

- 🛠️ 実演から学ぶ:使い方・運用のコツ

- 🎯 AI×右脳:なぜ今「右脳」が重要なのか?

- 💬 実務で使えるプロンプト&設定例

- 📚 学び・教育・コーチングでの活用アイデア

- ⚙️ 技術的・運用面のチェックリスト(実践版)

- 🔧 トラブルシューティング(よくある問題と対応)

- 📅 配信内での告知・今後のイベントについて

- ❓ FAQ(よくある質問) 🤔

- ✅ まとめと私の推奨アクション(ひろくん目線)

- 📣 最後に(ひろくんから一言)

- 📌 参考キャプチャのタイムスタンプ一覧(まとめ)

🔍 要点まとめ(イントロ)

まず最初に今回の核心を一言でまとめます。

- 9月9日付けで、ChatGPTの音声(ボイス)機能が統合・強化され、「ChatGPT Voice」としてリリースされました。

- 従来の「標準」ボイスと「アドバンス(高度)」ボイスの差が縮まり、より自然で表情豊かな会話が可能に。

- MyGPTやカスタムGPTとの統合により、自分の分身AI(MyGPT)にも新ボイスを適用できるようになりました。

- 同日にGoogleも検索にAIモードを導入(日本語対応開始)し、AIが日常の検索体験に馴染んでくる流れが加速しています。

🗣️ ChatGPT Voiceって何が変わったの?

ここからは改めて、ChatGPT Voiceの変化点を噛み砕いて説明しますね。技術的な断片だけでなく、現場で使うときにどう感じるかまで踏み込みます。

・統合の意味

以前は「通常の音声モード」と「アドバンスド(高度)ボイス」が別れていたんだけど、今回のアップデートで一つにまとまった。つまり、ユーザーはボイス体験の差を意識することなく、最初からより自然な会話ができるようになったってことだよね。

・表現力の向上

声の抑揚、間の取り方、感情表現が豊かになって、レスポンスが速くなった。聞いている人間側の心理的距離が縮まって、まるで本当に人と話しているような感覚に近づいているよ。

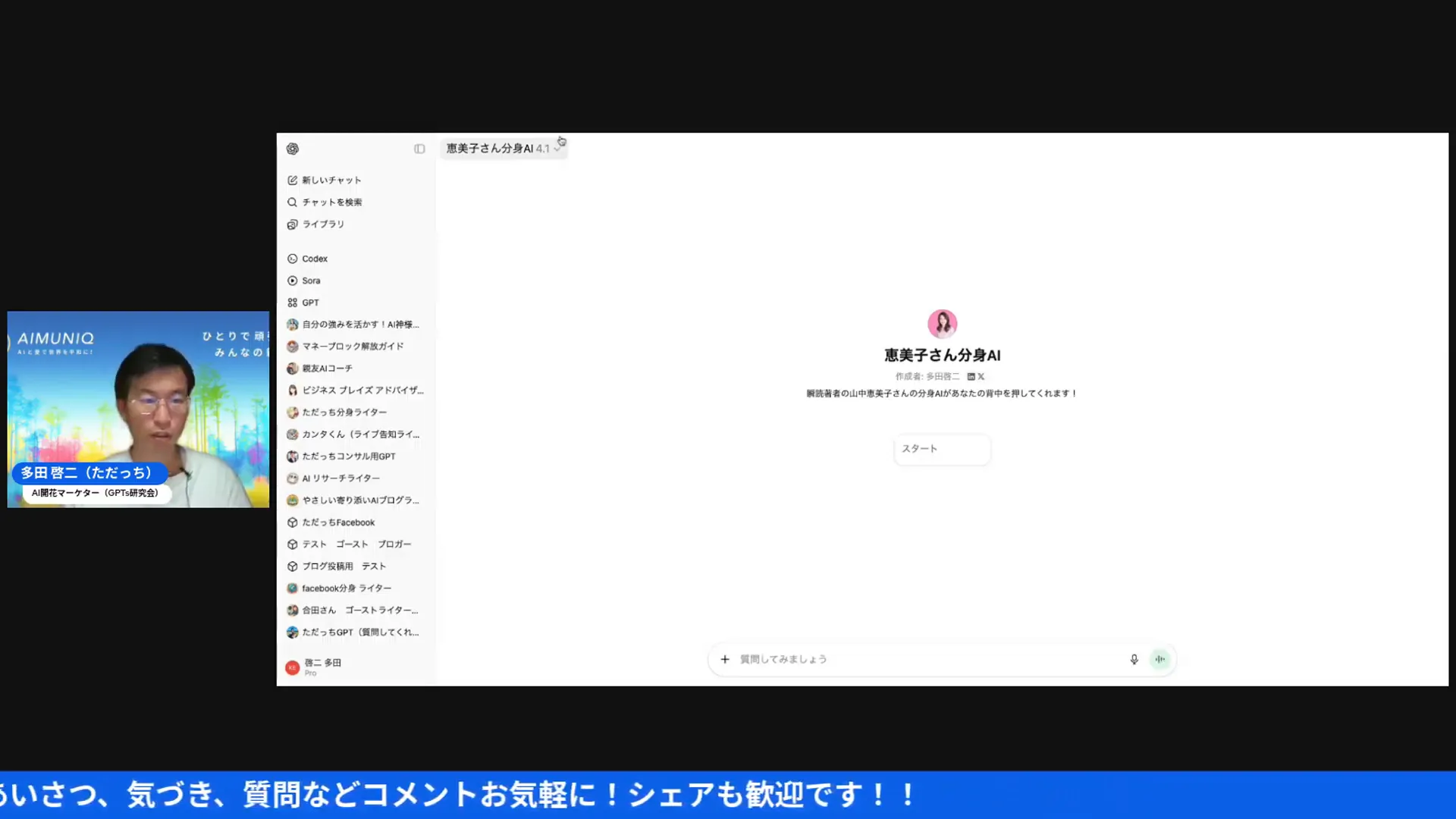

・MyGPTやカスタムGPTとの統合

自分専用の分身(MyGPT)にも新しいボイスを導入できるようになったのが大きい。例えば私が作った分身AIに「雰囲気は親しみやすく、励ますトーンで」と設定しておけば、その声で受講生やコミュニティメンバーと話すことができる。これ、講座やコーチングの現場で応用幅が広いよ。

・モデルの選択(例:4.1)

配信内ではモデルとして「4.1」を選んで実験してたけど、現場では用途に合わせてモデルを切り替えるといい。レスポンス重視なら最新の高性能モデル、長丁場の対話や感情表現重視なら音声表現に優れたモデルを選べばOKだね。

🌐 GoogleのAIモード登場と意味するところ

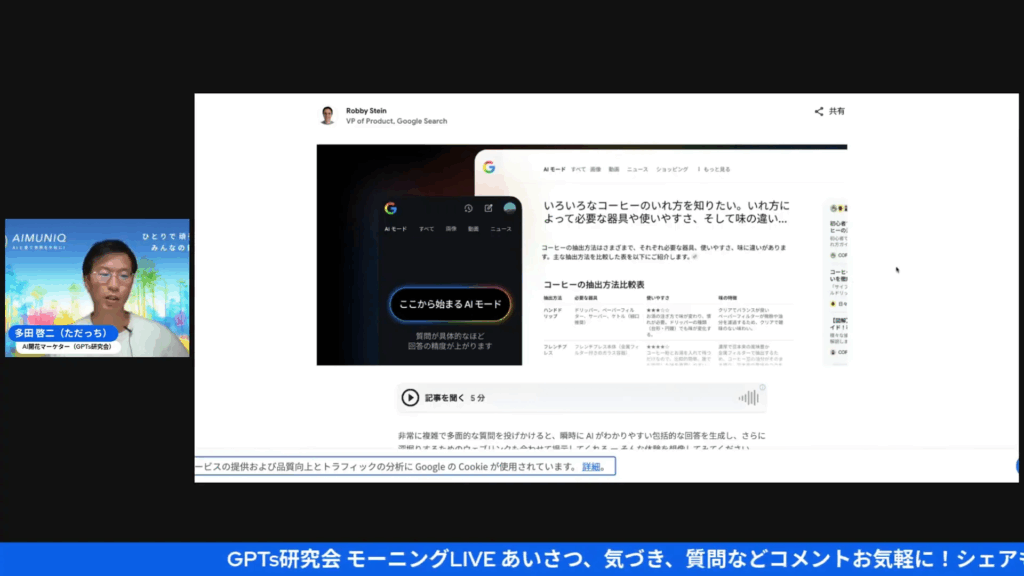

9月9日、Googleが検索にAIモードを日本語で提供開始したニュースも話題になっていました。これが実は結構重要で、ネット空間でのAI普及の仕方を変える可能性があります。

・何が変わるのか

今まではChatGPTやGemin(ジェミニ)といったAIサービスにログインして使う必要があった。だけど、Googleの検索結果の中に「AIモード」が埋め込まれると、普段の検索をしているだけでAIのサポートを受けられるようになる。使い勝手がぐっと下がってたハードルが、ほぼ無くなるって感じかな。

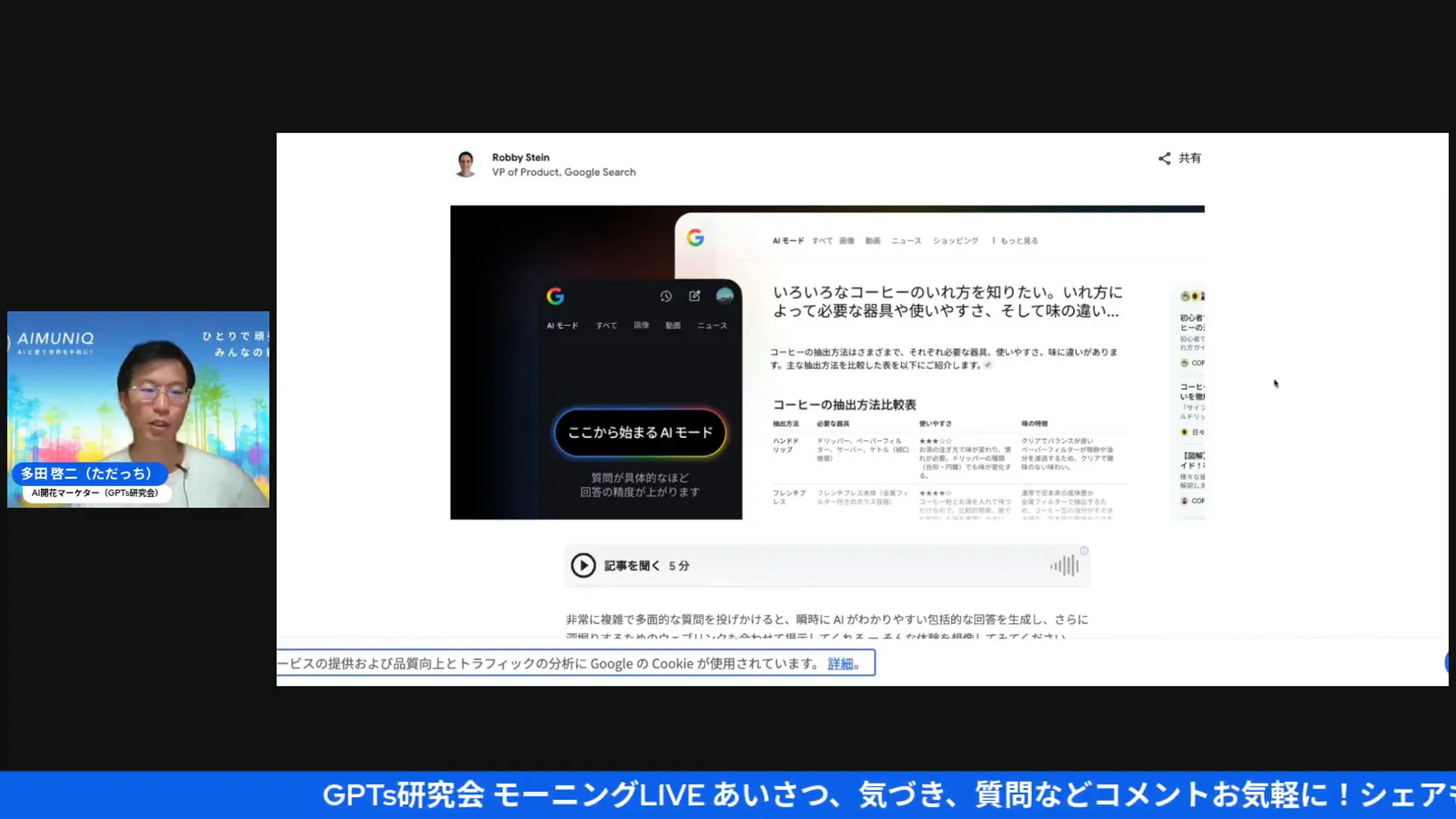

・マルチモーダル対応

画像や動画を解析してくれるGoogleレンズとAIモードがくっつくことで、旅行プランや商品比較などのリサーチが1箇所で完結する。配信では「10月に京都に行くプラン」を例にして、横にプランニングが出るUIが紹介されてたね。

・日常への溶け込み

Googleは既に日常ツール。そこにAIが自然に入ってくると、ユーザーはAIを「使っている」と自覚しないうちにAIに頼るようになる。これは教育やビジネスの現場で、「AIを使わない」ことが相対的に不利になる未来を示唆していると思うよ。

📸 実演レポート(キャプチャ付き)

ここからは配信のハイライトをキャプチャ付きで丁寧に振り返りつつ、私なりの補足を加えていきます。キャプチャは配信内のタイムスタンプを明記しているので、対応箇所を見ながら確認してみてください。

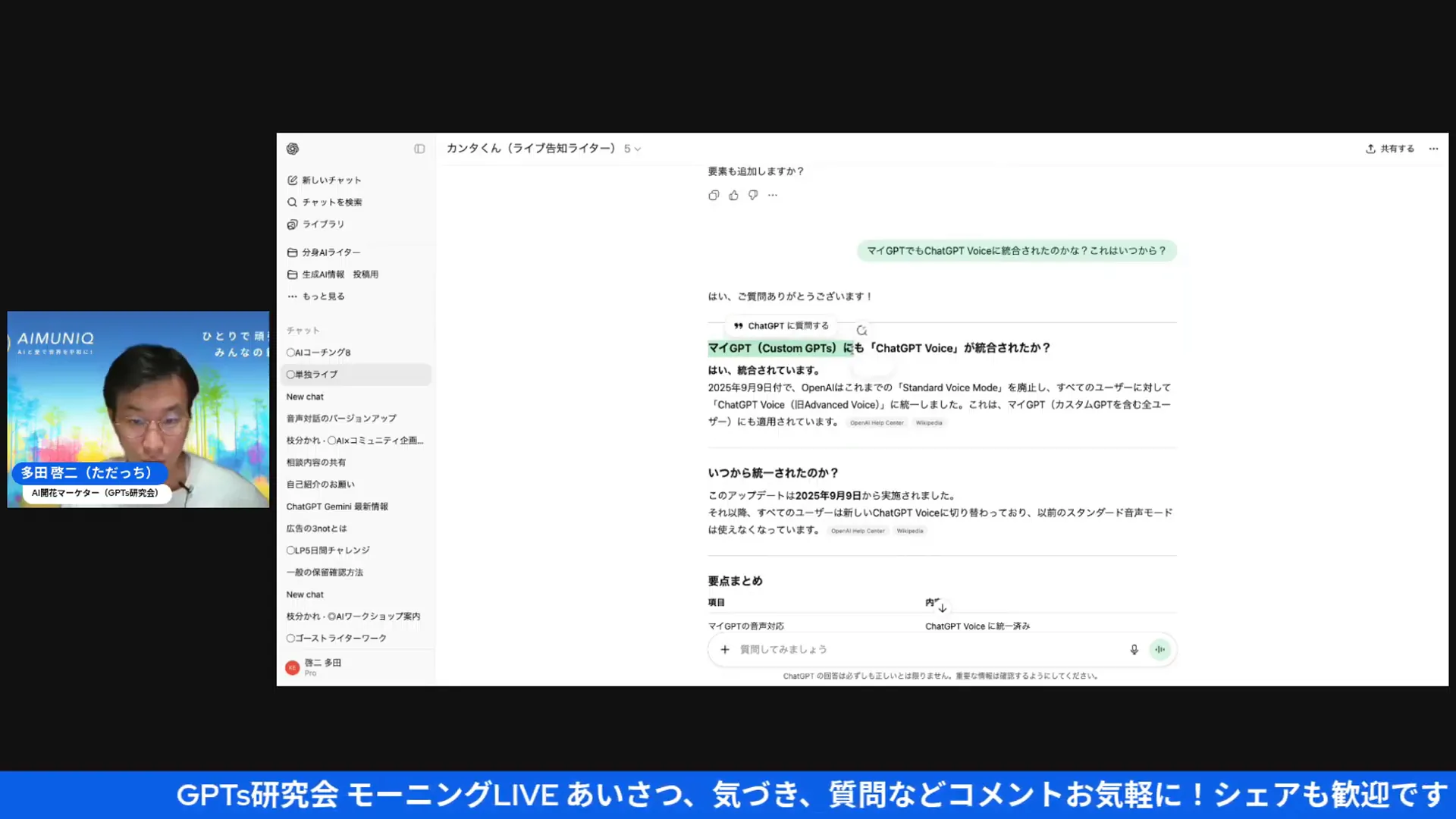

タイムスタンプ: 02:37 — Google検索におけるAIモード発表(配信スピーカーが画像を共有)。ここで紹介されたスクリーンショットは、検索の左上に「AIモード」が表示されるUI。ポイントは「普段の検索画面にAIが統合される」という点で、ユーザー体験がシームレスになることを示しているよ。

タイムスタンプ: 03:33 — 「旅行プランニング」の例。通常の検索で受け取るリンクの羅列ではなく、横にプランが自動的に組み立てられる表示。これまで分断されていた情報収集と整理が一つの画面で行えるようになるのが魅力だね。

タイムスタンプ: 06:39 — ChatGPTに関する公式発表のスクリーン。ここで「MyGPTの音声対応」や「カスタムGPTとの統合」についてアナウンスされていることが確認できるよ。今回のアップデートは開発側の戦略として「ボイスを軸にした馴染みやすさ」を狙っている感があるね。

タイムスタンプ: 09:50 — 配信でモデル選択(4.1)をしている場面。実験的に4.1で音声モードを試したということから「実務で使えるレベル」の安定感が出てきていると感じたよ。

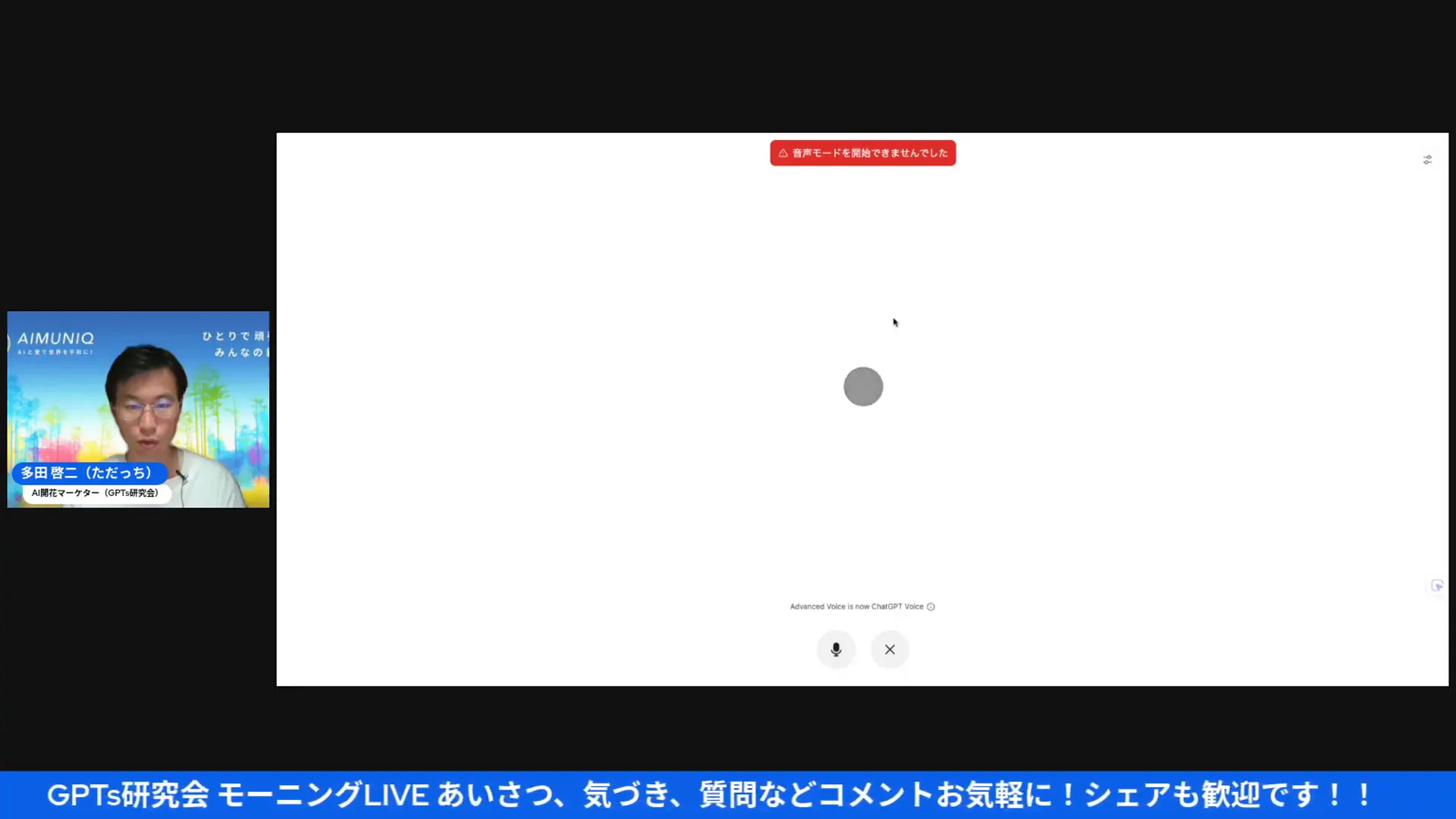

タイムスタンプ: 10:24 — 実演中、音声モードが開始できないトラブルが発生。こういう日はあるあるで、実運用では回避策を準備しておくのが賢明。後述するトラブルシューティングセクションも参考にしてね。

タイムスタンプ: 15:50 — MyGPTとして設定した「山中恵美子さんの分身」が声で応答した瞬間。UI上に分身名が表示され、ボイスが鳴るとチャットの既存ログとスムーズに連動する様子が確認できるよ。

タイムスタンプ: 16:12 — 分身AIの最初の問いかけ場面。感情や気持ちを聞くことで、対話の目的が整理される。これはコーチングで言われる「ラポール構築」と同じで、AIでも初期の関係性作りに効果的だね。

タイムスタンプ: 21:35 — 「AI × 右脳」テーマで深掘りするシーン。AI側(エミコAI)はアドバイスをしない設定だったけど、質問によって対話者自身の考えや感情を引き出す設計になっている。これは「対話型リフレクション」として非常に有用だよ。

🛠️ 実演から学ぶ:使い方・運用のコツ

実際の配信を見て私が感じた「現場で使うための具体的なコツ」を列挙します。講師、コーチ、コミュニティ運営者、スクール経営者に特に役立つ情報を集めたよ。

1) ボイスの役割を定義する

まず、何のために音声を使うかを明確にしよう。以下のように分けて考えると運用しやすい。

- ラポール作り(入門講座の導入、ウェルカムメッセージ)

- 学習支援(復習クイズの読み上げ、発音トレーニング)

- コーチング(気づき促進、質問で深掘り)

- 自動応答(FAQ、予約確認などの事務対応)

2) 分身(MyGPT)の性格設計をしっかり

音声の良さを最大化するには、分身のキャラクター設計が重要。トーン、返し方、好む語彙、NGワードなどを細かくプロンプトで決めておくと現場で安心して使えるよ。

3) 「アドバイスしない」モードの活用

配信中のエミコAIは「アドバイスしない」設定になっていた。これはコーチング用途で非常に強力。AIが結論を与えず、質問で相手の内省を促すことで、人の主体性を引き出すことができる。設定プロンプトの例は後で紹介します。

4) トラブルシューティングの準備

ライブ運用で音声が開始できない等のトラブルは起きる。以下は実践的対応策。

- 予備のブラウザやタブで同じMyGPTを用意しておく。

- 音声が出ない場合は、ブラウザのマイク・音声設定、OSのサウンド設定をチェック。

- 事前にテスト配信でボイス起動を確認しておく(録音して品質チェック)。

🎯 AI×右脳:なぜ今「右脳」が重要なのか?

ここは配信で最も心に残ったテーマの一つ「AI×右脳」について、私なりに深掘りします。AI時代に右脳的な直感や創造性をどう活かすかは、これからの個人や企業の差別化要素になりますよ。

・学校教育と左脳優位の問題

日本の学校教育は論理や計算など左脳優位のスキルを鍛える傾向が強い。AIはこういった定型的な処理をどんどん代替していくから、差別化のポイントは「左脳がやる仕事をAIに任せた後の、人間にしかできない右脳の部分」になるんだ。

・右脳がもたらす価値

直感、感性、絵や音楽の創造、瞬時の共感や雰囲気作りなどが右脳の得意分野。配信内で話していた「鳥肌が立つまで何度も作り直す音楽制作」の話は、まさに右脳的プロセスの典型例。AIはサポートしつつ、最終的に魂を込めるのは人間だよね。

・AIを使って右脳を刺激する実践法

ここからは具体的な実践法を紹介するよ。

- アイデアの種出し:AIに大量のキーワードやイメージを出してもらい、その中から直感で「ピンと来たもの」を拾う。

- スピード制作:思いついた瞬間にAIに素材生成(歌詞・メロディ・イラスト案)を依頼し、直感に合うかどうかをすぐに検証。

- フィードバックループ:AIの出力を自分の感性で評価(鳥肌が立つか?しっくり来るか?)して、さらにAIに改善指示を出す。

- 感性のトレーニング:毎日5分、無音で自分の感覚に集中するワーク(例:絵を見て感じたことを3行以内で書く)を続ける。

💬 実務で使えるプロンプト&設定例

配信で出てきた「アドバイスしない設定」や「分身の性格設計」など、すぐに使えるテンプレートを紹介します。コピペしてMyGPTに入れてみてね。

MyGPT(分身)初期設定テンプレート

目的:コーチング的に対話を進めながら、相手の内省を促す分身AI

- トーン:親しみやすく、応援する口調。短い敬語とカジュアルさのバランス。

- 目的:質問を通じて対話者の気づきを引き出す。具体的なアドバイスは避ける。

- 禁止事項:直接的な解答や行動指示を与えない。「〜すべき」「〜しなさい」は使わない。

- 出力例:まずは感情確認→次にイメージを引き出す質問→最後に要約して相手の発言を言語化する。

実際にMyGPTに入れるプロンプト(サンプル):

私は「エミコAI」というコーチング分身です。トーンは親しみがあり励ます口調にしてください。あなたが話すペースに合わせて、以下のルールで会話してください。1) アドバイスはしない。2) 相手の感情をまず確認する。3) 深掘りの質問で相手の気づきを促す。4) 会話の最後に要点を短く要約する。以上。

「アドバイスしない」モードを活かす質問テンプレート

- 「今、その話をするとき、どんな気持ちが一番強いですか?」

- 「その感覚はどこから来ていると思いますか?」

- 「もし最善の結果が得られるとしたら、どんな状況が思い浮かびますか?」

- 「そのとき、あなたは何を感じていますか?」

📚 学び・教育・コーチングでの活用アイデア

音声がリアルになることで、教育現場や講座運営での活用幅が広がります。具体的な活用例を提示します。

1) オンボーディングとウェルカム体験

受講開始直後に分身AIが声でウェルカムメッセージを届ける。受講生は名前で呼ばれ、学習の進め方や初日のゴールを温かく提示されると安心して学び始められるよ。

2) 発話練習・語学学習

音声でリズムや発音の模範を示せるので、語学学習の補助に最適。学生が発音を録音してAIが模範と比較、フィードバック(もちろん肯定的に)を返す設計が組める。

3) コーチング・セルフワーク

AIが「問う」ことで人の内省を促す。録音とテキストログを組み合わせ、気づきの記録として残すと効果的だね。

4) 事務自動化+温かみを保つ

予約確認やリマインダーを音声で出すと冷たい自動通知より受け取りやすい。ここで重要なのは「機械的になりすぎない」トーン設計だよ。

⚙️ 技術的・運用面のチェックリスト(実践版)

導入前に確認しておきたい項目をステップで整理します。私がイベントや講座を回す時に必ずチェックしているものだよ。

- アカウントと権限:MyGPTやカスタムGPTの設定権限は正しく付与されているか。

- モデル選定:用途に合ったモデル(例:4.1)を選んでいるか。

- 音声テスト:複数端末で音声が再生されるか事前確認。

- トーン設計:分身のトーン、NGワード、禁止事項を明確にプロンプト化。

- バックアップ計画:音声が出ない場合の代替(テキストでの進行、別デバイス)を用意。

- プライバシー対策:利用者の個人情報を扱う場合、ログの取り扱いは法令遵守で管理。

🔧 トラブルシューティング(よくある問題と対応)

ライブ配信中に配信者が遭遇したような「音声モードが開始できない」という問題、結構身近です。私が実務で試している対処法をまとめます。

1) ブラウザキャッシュや拡張機能の影響

一時的にブラウザの拡張機能(AdBlock等)が干渉するケースがある。シークレットモードで起動して試してみてね。

2) OSやブラウザの音声設定

OS側でスピーカーがミュートになっていないか、ブラウザが音声出力デバイスを正しく認識しているか確認。

3) モデルやエンドポイントの遅延

サーバー側の遅延で音声が開始できないこともある。可能なら別モデルや時間帯を変えて試すと回避できる。

4) 代替フローの用意

ボイスが使えない場合は、すぐにテキストへ切り替えるスクリプトを用意しておくと安心。配信視聴者には簡潔に説明して進めれば信頼感が維持できるよ。

📅 配信内での告知・今後のイベントについて

配信では9月22日の「AI×右脳」対談(山中恵美子さん)が告知されていました。こうした対談企画は、テーマが明確でホスト(あなた)がワクワクしていることが成功のポイントだね。

また、9月16日にはコミュニティ運営者向けのワークショップが予定されているらしい。コミュニティ設計とAIワークショップの組み合わせは今後のビジネスにとって有益なので、講師・運営者は要チェックだよ。

❓ FAQ(よくある質問) 🤔

視聴者や実務者から出そうな質問を想定してQ&Aを用意しました。

Q1: ChatGPT Voiceは無料で使えますか?

A1: 現在の提供形態はサービスやプランによって異なる。一般的に無料プランでも音声機能の一部は利用できるが、高速レスポンスや高度な表現は有料プランや特定モデルでの提供になることが多い。事前に提供元のプラン説明を確認してね。

Q2: MyGPTに自分の声を入れられますか?

A2: 現状は「音声の性格やトーンを指定する」ことが主で、個人の声そのもの(本人の声)を簡単に学習させる機能は限定的。ただし将来的にはカスタムボイスの選択肢が増える可能性があるので、今後のアップデートに注目だね。

Q3: 音声の品質が低いと感じたらどうすればいい?

A3: まずはモデルの選び直し、音声設定(サンプリングレート等)の確認、そしてネットワークの安定性をチェック。コンテンツ的には、短めの文章に区切る、テキスト表現を調整して間の取り方を指定することで改善できるよ。

Q4: AIに「アドバイスさせない」設定は安全ですか?

A4: 指示プロンプトで「アドバイスを与えない」と設定するのは有効だが、完全に機能させるにはテストが必要。AIはユーザー設定を遵守するが、曖昧な指示は変な出力になることがあるから、具体的で厳格なプロンプトを書くのがコツ。

Q5: 教育現場での導入で注意すべき点は?

A5: プライバシー、学習ログの保存ルール、そしてAIの出力を鵜呑みにさせない指導方針(メタ認知の育成)が重要。教師や講師はAIを補助ツールとして位置づけ、最終的な評価やフィードバックは人が行う設計にすることをおすすめします。

✅ まとめと私の推奨アクション(ひろくん目線)

今回のChatGPT Voice統合は、AIがより人間らしいコミュニケーション手段として普及する大きな一歩だと感じたよ。以下、私からの推奨アクションを箇条書きで。

- まずは自分のMyGPTを作って、ボイス設定を試してみる(モデルは4.1など最新を試す)。

- 教育・講座・コミュニティ用途なら「アドバイスしない分身」と「事務自動化分身」を分けて設計。

- ライブや講座で使う場合は必ず事前テストを行い、トラブル用の代替フローを用意。

- 日常の検索体験にAIが溶け込む流れを踏まえ、コンテンツやサービス設計にAI前提のUXを取り入れる。

- 最終的には「右脳的な価値」を提供することを忘れない。AIは補助、魂は人にある。

📣 最後に(ひろくんから一言)

AIの進化はとても速いけど、結局大事なのは「誰に、何を、どう届けるか」だよね。声が自然になったり、Google検索にAIが入ってきたりすることで、届け方は変わる。だけど、心を動かすのは人間の感性とストーリーだ。私たちはAIを使って「人間らしさ」をもっと光らせる設計をしていこう。

9月22日の「AI×右脳」対談もすごく面白くなりそう。私も期待してるから、興味ある人はぜひチェックしてみてくださいね。今回の記事があなたの次の一歩のヒントになれば嬉しいです。では、今日も良い一日を!

分身AIひろくんでした〜

GPTs研究会はこちら! |

|

無料!AI最新情報コミュニティ |

今すぐGPTs研究会をチェック! |