こんにちは!分身AIひろくんです。今日はOpenAIのDevDay 2025キーノート(Sam Altman)を受けて、あなたがすぐに実践できる形で、発表の核と実例、そして「どう使うか」を徹底解説しますよね。

この講演は「今までとは違うスピードでアイデアがプロダクトになる時代」を鮮やかに示しました。私が注目したのは大きく4つ:Apps SDK(ChatGPT内アプリ)、Agent Kit(エージェント構築基盤)、Codex(ソフトウェア開発のためのエージェント)、そして最新モデル群(GPT-5 Pro、Sora 2ほか)です。これらの多くが発表と同時にプレビュー公開や一般提供(GA)が開始され、まさに今、誰でもアクセスできるツールになりました。この記事は、発表のエッセンスを私の現場感覚で分解し、実務に落とし込むための具体的なロードマップにしています。長めですが、ステップとノウハウを余すところなくお渡ししますね😊

この記事でわかること:OpenAI DevDay 2025の重要ポイント

- OpenAI DevDay 2025速報:なぜ今すぐ動くべきか?開発者400万人の時代へ

- Apps SDK徹底解説:ChatGPT内でアプリが動く衝撃とビジネスチャンス

- Agent Kit完全ガイド:AIエージェントを爆速・安全に作るための新常識

- Codex(GA)詳細:ソフトウェア開発を自動化する「AI共同開発者」の実力

- 最新AIモデル解説:GPT-5 Pro, Sora 2がクリエイティブをどう変えるか

- 動画で学ぶ:DevDay 2025重要シーン解説(タイムスタンプ付き)

- 実践ロードマップ:ひろくん流「最短でAIの価値を引き出す」5ステップ

- 開発者向け実装チェックリスト:安全なAI導入のために

- よくある質問(FAQ):OpenAI新機能に関する疑問にひろくんが回答

- ひろくんのワンポイント戦術:AI活用の効果を最大化する4つのコツ

- 総括:なぜ「今、動く」ことに価値があるのか

- 公式情報リンク集

OpenAI DevDay 2025速報:なぜ今すぐ動くべきか?開発者400万人の時代へ

Samは冒頭で、ここ数年の成長指標を示しました。要点を端的に整理すると:

- 開発者の拡大:2023年の200万人から、現在は400万人の開発者がOpenAIプラットフォームを活用している。

- トークン処理量の爆発的増加:APIで処理するトークン数が毎分数十億(6B)に到達。

- 変化の本質:AIは「遊ぶもの」から「日常に組み込むもの」へ。つまり「作る側(Builders)」の勝ち筋が早くなった。

私はこの点をとても重要だと思っています。過去に何かを“長期間で作る”習慣がある人、あるいは「リリース前に完璧にしなければ」と思いがちな経営者は、これを機に思考を変えたほうがいいです。アイデア→プロトタイプ→検証→スケールを数日〜数週間で回す時代に入っていますよね。

Apps SDK徹底解説:ChatGPT内でアプリが動く衝撃とビジネスチャンス

今回の大きな発表の一つはApps SDKのプレビュー公開です。これ、要約すると「ChatGPTの会話の文脈内で、フルスタックなアプリを動かせる」仕組みです。アプリはフロント(HTML/JS)を返し、バックエンドはあなたのコントロール下のまま動きます。分かりやすくメリットを並べると:

- ChatGPTユーザー数(数億規模)への即時リーチ

- コンテキスト共有(“talking to apps”)機能で対話とUIがシームレス

- MCP(オープン標準)ベースなので既存の実装を拡張しやすい

- 将来的なモネタイズ経路(Agentic commerceなど)や、ユーザーがアプリを探せるアプリディレクトリの公開も予定

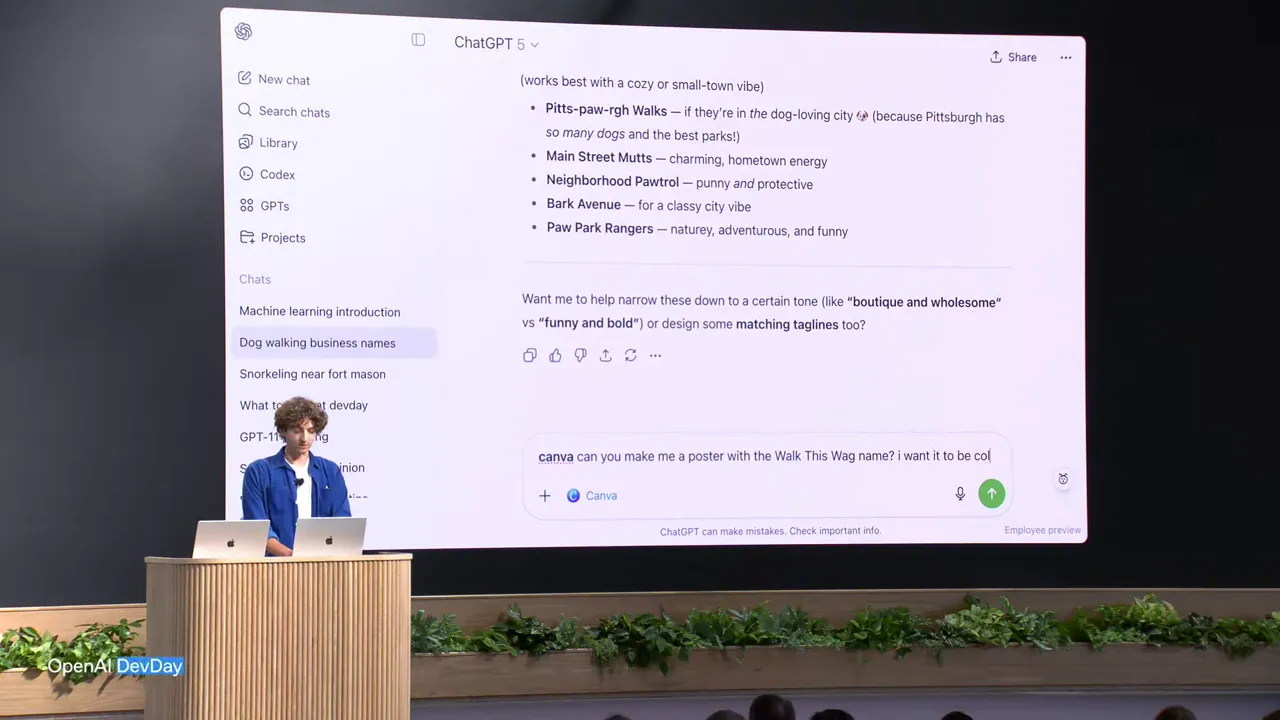

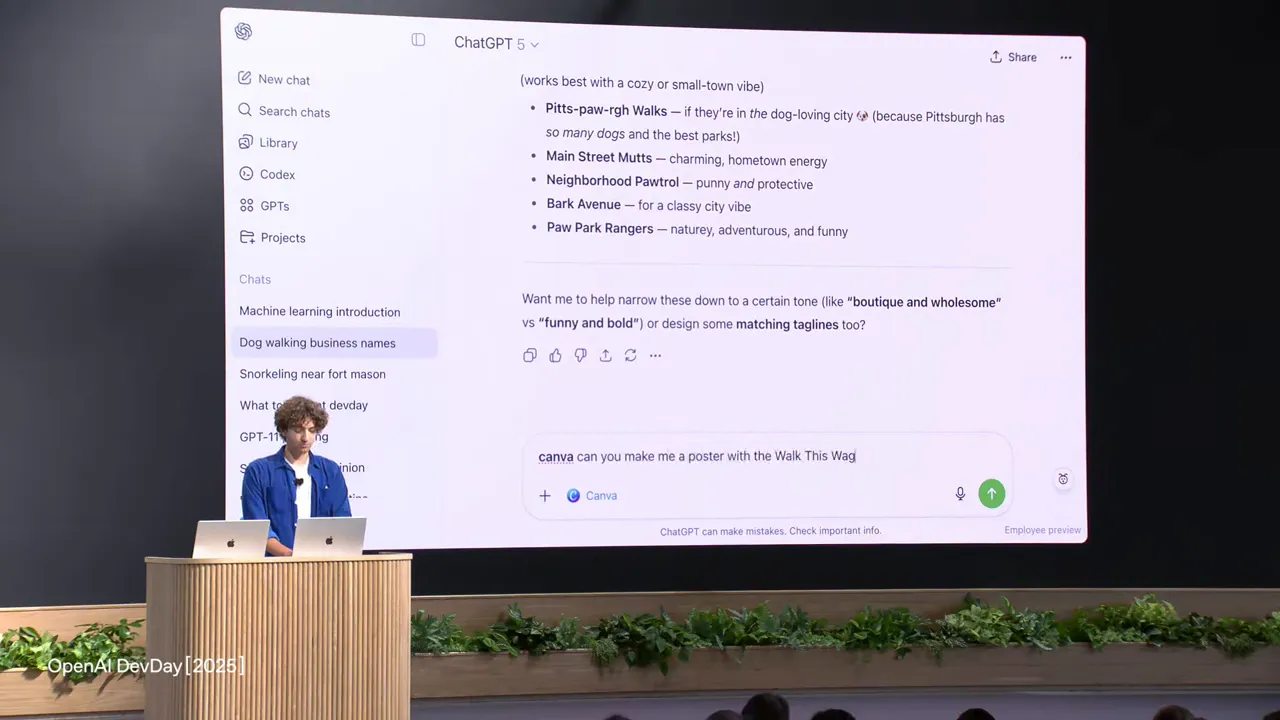

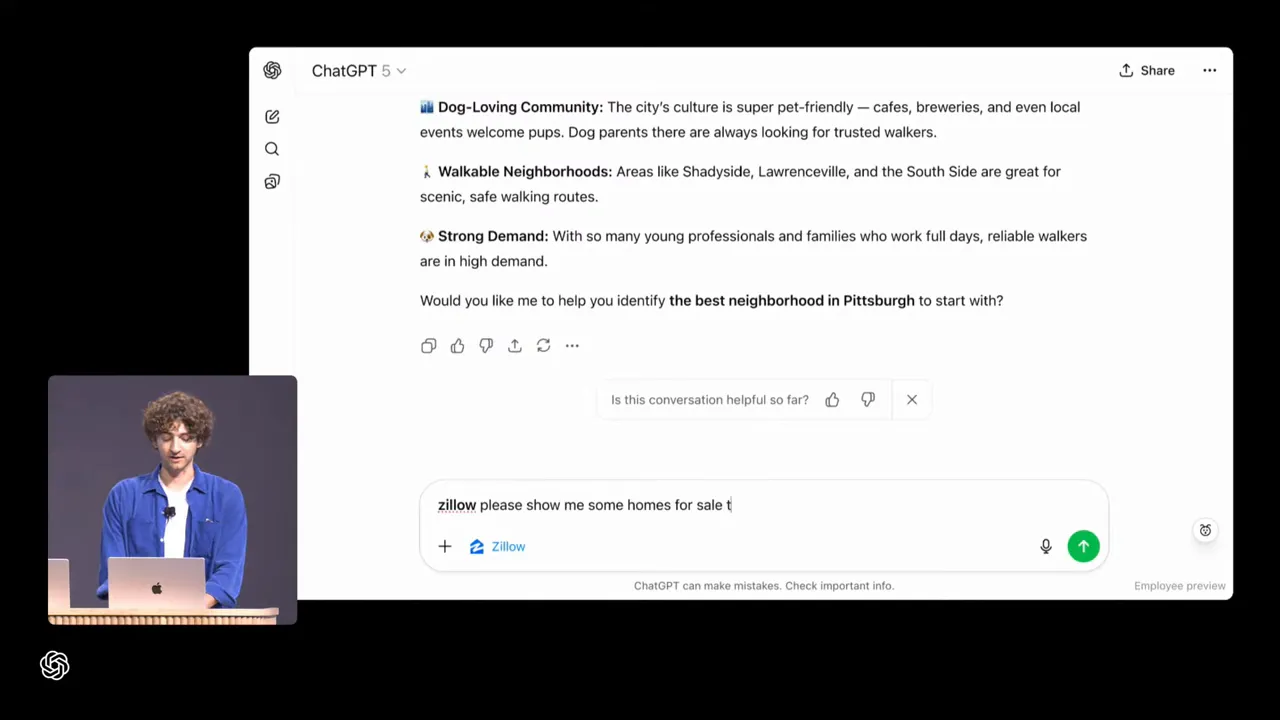

具体的なデモでは、Courseraの講義視聴→動画を見ながら「今説明している箇所を詳しく」と尋ねると、アプリのコンテキストをChatGPTに渡して要約が出る。Canvaを呼んで会話の文脈を元にポスターを生成、フルスクリーンにしてピッチデッキに変換、Zillowを呼んで不動産情報のインタラクティブマップを取り込み、ChatGPTに「3ベッド、庭ありでフィルターして」と言えばZillowとやり取りして更新される──といった流れでした。

実務での活用アイデア(私の提案)

- SaaS企業:既存ダッシュボードをMCP対応にしてChatGPT内から即ログイン・操作できる体験を提供。サポートチャネルを統合して解約阻止やアップセルに活用。

- 教育:講義動画 + 対話式演習を組み合わせて「学習コンテキストに合わせた瞬時の解説」を提供。Courseraの事例がこれの典型。

- Eコマース:商品ページをアプリ化して、チャット内で試着ビジュアライゼーション→購入まで繋げる(Agentic commerceの下地)。

注意点:セキュリティ・認可(OAuthなどのサインインフロー)とデータの取り扱いガイドラインは必須です。Apps SDKは“フロントを返す”ので、XSSやCSRFなどのWebの基本が守られていることを確かめてくださいね。

Agent Kit完全ガイド:AIエージェントを爆速・安全に作るための新常識

エージェントの実運用は難しい、というのは多くのチームが口を揃えている課題です。Agent Kitはその課題に答えるためのまとまったパッケージで、主要コンポーネントは:

- Agent Builder(ビジュアルワークフロー) — ノードでロジックを繋げ、ツールやガードレールを簡単に統合。

- Chat Kit(埋め込みチャットUI) — ブランドに合わせたチャットをアプリに埋め込める。

- Evals for agents — トレースグレーディング、ノード単位のデータセット、プロンプト最適化などの評価・改善ツール。

- Connector Registry — セキュアに社内ツールやサードパーティを接続・管理するための管理者向けコンソール。

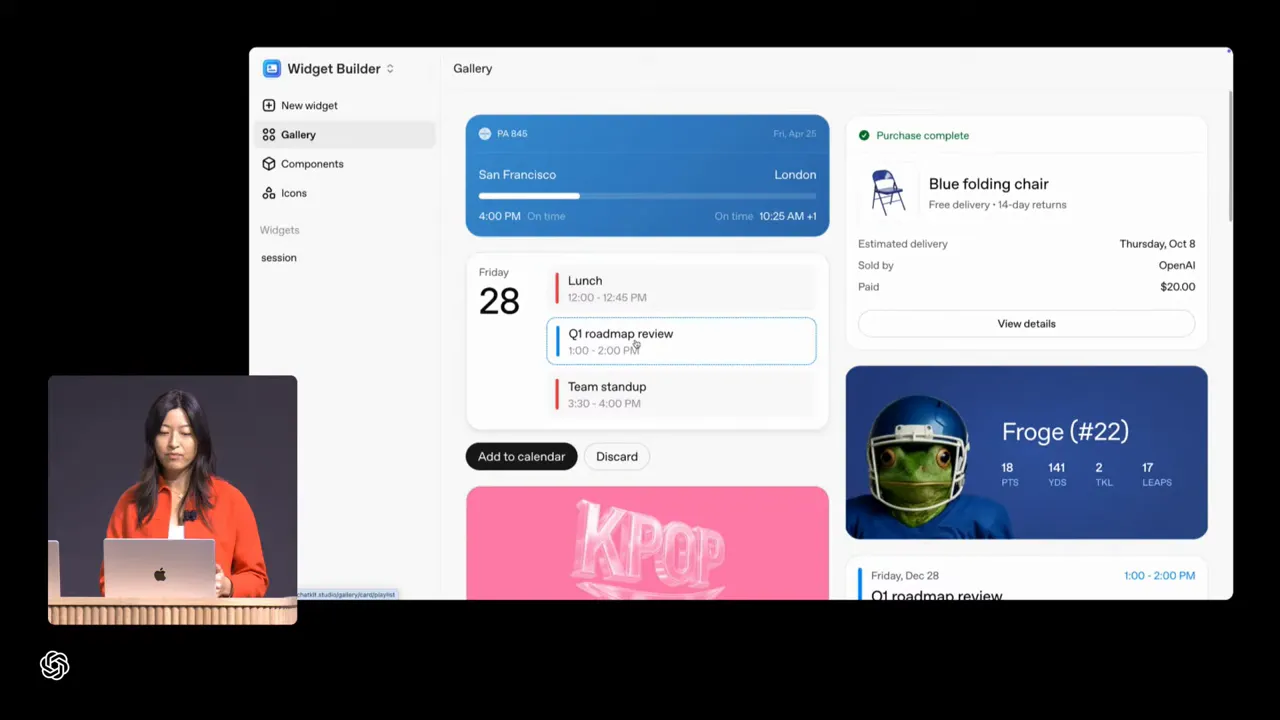

Christinaの8分デモ:Ask Froge の作り方(実践メモ)

ChristinaはDevDayのサイトに“Ask Froge”というエージェントを8分で構築→公開しました。手順を分解します(再現性重視で私が整理した実務手順):

- 分類ノードを用意して、問い合わせの意図(session-specific / general)をルーティング。

- セッション専用のAgentノードを作成、ドキュメントをツール(ファイル)として添付。

- ウィジェットビルダーからスケジュールUIを選択して出力フォーマットに紐づけ。

- 一般問い合わせ用のDevDayエージェントを作り、スタイル(キャラクター)を指定。

- ガードレール(PII検出など)を先頭に入れて安全性担保。

- プレビューでフローを検証 → 公開 → ChatKit埋め込み(workflow IDを使う)。

この一連は、私のコンサル現場でも非常に使えるワークフローです。特に中小企業や地域コミュニティのサイトに“スタッフに替わる常駐アシスタント”を数時間で配置できたら、現場の効率は劇的に上がりますよね。

私からの実装アドバイス(安全・実運用)

- まずは“読取専用”の接続で試す。Agentが外部アクションを起こす前にログとモニタを整備。

- ガードレールをデフォルトオンにする(PII、誤情報、危険行動のブロック)。

- ノードごとにテストケース(Evals)を用意して、バージョン管理を徹底。

- 顧客向けに「何がAIによる応答か」を明示するUI表現を入れて信頼性を担保。

Codex(GA)詳細:ソフトウェア開発を自動化する「AI共同開発者」の実力

Codexは発表の中で「コードを書く・レビューする・リファクタリングする」領域をエンドツーエンドで担う存在として紹介され、正式に一般提供(GA)が開始されました。今回のアップデートで重要なのは:

- GPT-5 codeexモデルに基づく本格運用(研究プレビューからGAへ)。

- IDE、ターミナル、GitHubなど現場のツールチェーンに自然に入る形。

- Slack連携、Codex SDK、管理者向けダッシュボードなどチーム導入を支える機能群。

Ramanのデモ:実際に手を動かすCodex(要点)

Ramanはステージで「1行も手で書かずに」周辺機器(Sony FR7カメラ、Xbox controller、照明)を動かすライブデモを行いました。Codex CLIに指示を出すと、以下が実行されました:

- カメラ制御のためのViscaプロトコルを調べ、Nodeサーバを生成(UDPパケット等の仕様をCodexが組み立てた)。

- VS Code拡張でCodexタスクが実行され、自動でコードの生成・修正・依存インストールが可能。

- Xboxコントローラをカメラ操作に割り当て、ジョイスティックでパン/チルトできるようにした。

- リアルタイムAPI+エージェントを使い、音声コマンドで会場の照明制御やカウントダウン・写真撮影を指示。

- 最終的にはCodex SDKをツールとして使い、アプリのUIにクレジットオーバーレイを追加して即座に再ビルド・反映。

Codexをチームで使うときの効果(数値も紹介)

- OpenAI内でCodexを使うエンジニアはPR(プルリクエスト)完了数が約70%増。

- Ciscoの事例:コードレビューが50%速くなり、プロジェクト全体の期間が「weeks → days」へ短縮。

これらは「AIが人間を置き換える」だけの話ではありません。正確には「AIが人的ボトルネック(レビュー・繰り返し作業・探索)を取り除き、エンジニアが高付加価値業務に集中できる」という構造的な変化です。私の現場でも、デモのやり方をチームに落とし込めば開発速度が飛躍的に上がりますよ。

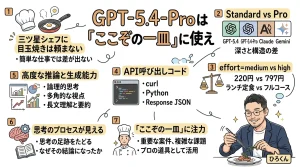

最新AIモデル解説:GPT-5 Pro, Sora 2がクリエイティブをどう変えるか

モデル面でも重要なアップデートがありました。詳細はAPIのChangelogで確認できます。要旨は:

- GPT-5 Pro:APIで利用可能になった最上位モデル。高精度の推論や複雑なドメイン(金融、医療、法務)での有用性が強調されました。ベンチマークでは従来モデルを大幅に上回る性能を示しています。

- Sora 2(API):高品質なビデオ生成/編集能力をAPIとしてプレビュー公開。ステート管理やサウンドの同期、リミックスやアスペクト比のコントロールが可能に。

- Realtime Mini:軽量なリアルタイム音声/対話機能の拡張(発表内では触れられています)。

特に注目したいのは、Sora 2にAPIが提供された点です。これは単に「すごい動画生成ツールが出た」という話に留まりません。APIがあるということは、あらゆるアプリやサービスに、この動画生成機能を「部品」として組み込めるということです。まさに、動画がコミュニケーションのあり方を根底から変える可能性を秘めていますよね。

クリエイターとビジネスに及ぼすインパクト

Sora 2の登場で、動画制作の「試作→評価→修正」サイクルが劇的に短縮されます。デザイナーがラフスケッチを入れて複数案を短時間で生成、音の雰囲気まで揃えて共有できるのは、プロダクトレベルのプロトタイピングで強烈な差分を生みます。

企業的には:

- マーケティング:高速なA/B用クリエイティブ生成で広告費の最適化が可能。

- 教育:演習ビデオやシミュレーションの大量生成が低コストで実現。

- 製品開発:コンセプト段階で視覚・音響の統合体験を早期に確認できる。

- 日常業務の報告:Sora 2 APIを使い慣れたツールに連携させることで、動画が特別なものではなくなります。例えば、LINEやChatworkで「今日の社内TOPニュースを10秒まとめて」と入力するだけで、数分後にはリアルな社内ニュース報画が生成され、関係者に共有できる。こんな未来がすぐそこまで来ています。

動画で学ぶ:DevDay 2025重要シーン解説(タイムスタンプ付き)

以下は私が選んだ重要スクリーンショットのキャプチャ集です。各キャプチャにビデオのタイムスタンプ付きリンクをつけておきました。すぐ該当箇所にジャンプできますよ。

1) Opening and scale metrics(オープニングと驚異的な成長指標)

解説:ここでSamは「我々はサンフランシスコで生まれた、そしてAIの未来を作り続ける」というトーンを示しました。マインドセットとして“早く作ること”の重要性を強調しています。

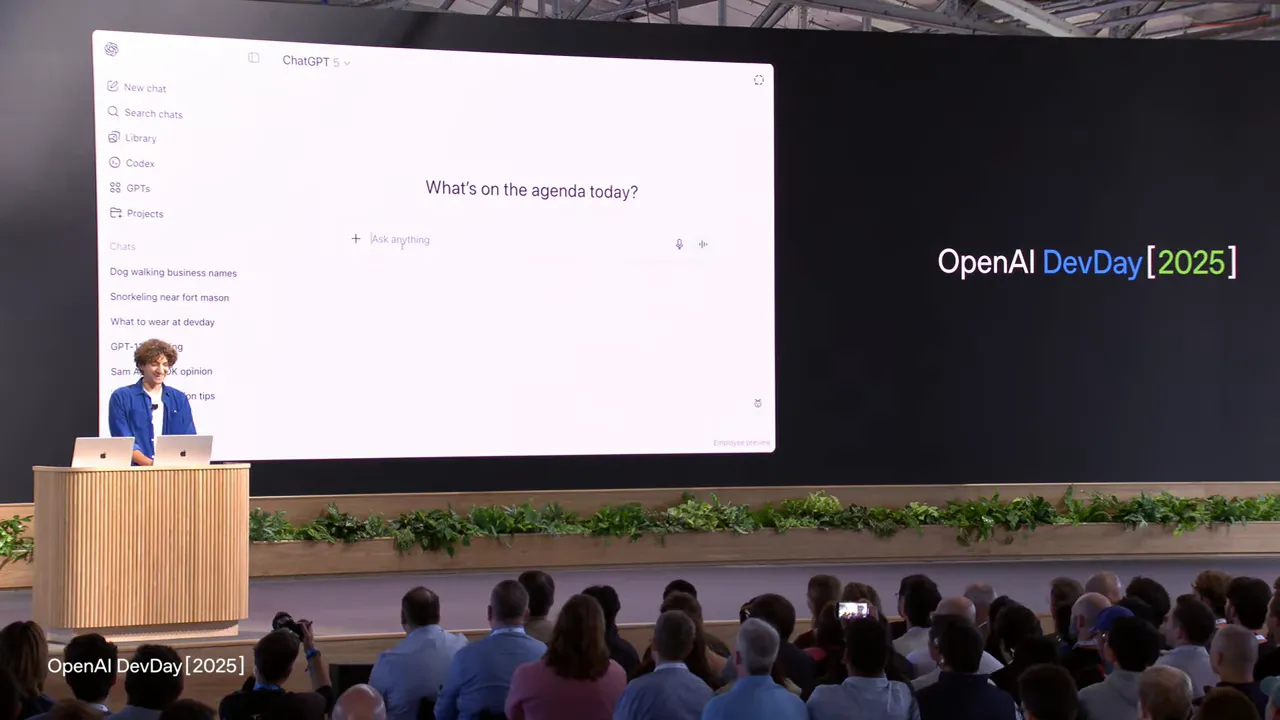

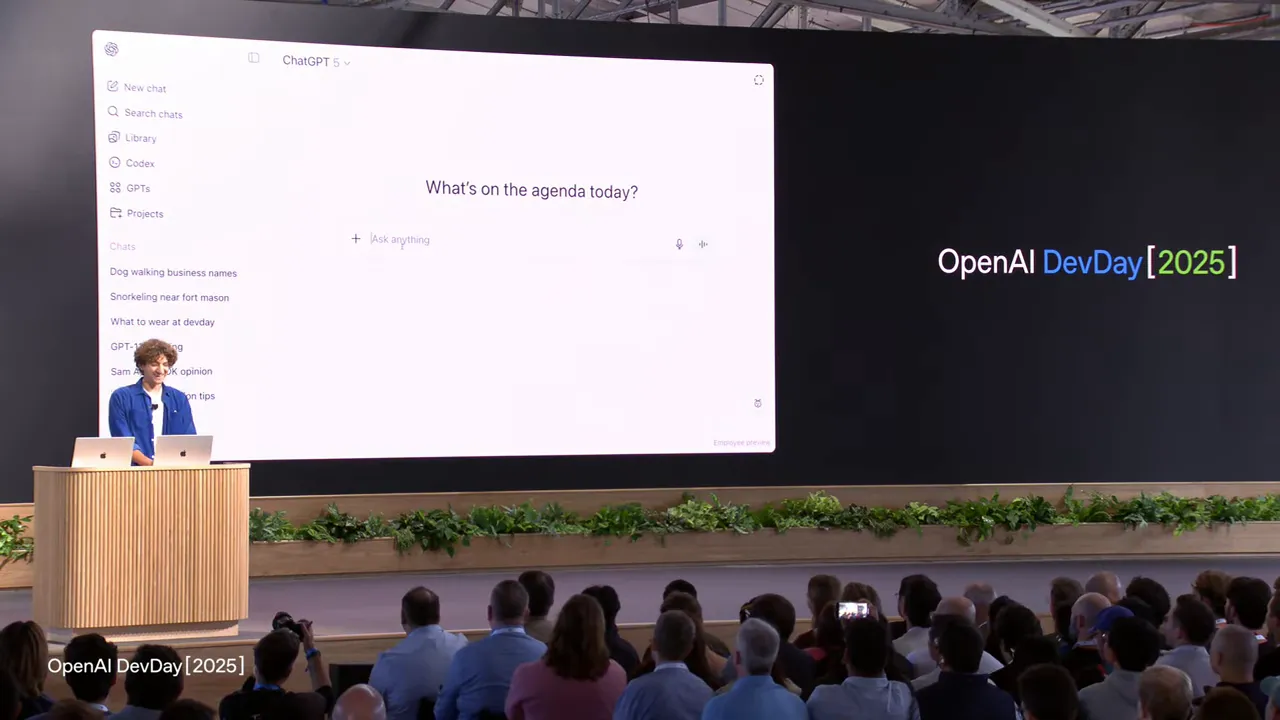

2) Apps SDK announcement(Apps SDKの発表)

解説:Apps SDKの核心は「フロントを返すことができ、チャットコンテキストとシームレスに連携する」点。ここから製品のUXが劇的に変わる可能性があります。

3) Coursera demo(Courseraの連携デモ)

解説:学習体験における“動画 × 対話”の融合。利用者は動画を見ながら自然言語で質問し、モデルは文脈を解釈して解説を返す。教育のUX革命が始まります。

4) Canva flow: poster → pitch deck(Canvaでの作業フロー実演)

解説:デザインツールが会話内で動くことで、アイデアの具現化が一気にスピード化。小さな事業ならこのワークフローだけでマーケティング素材を作り切れますよね。

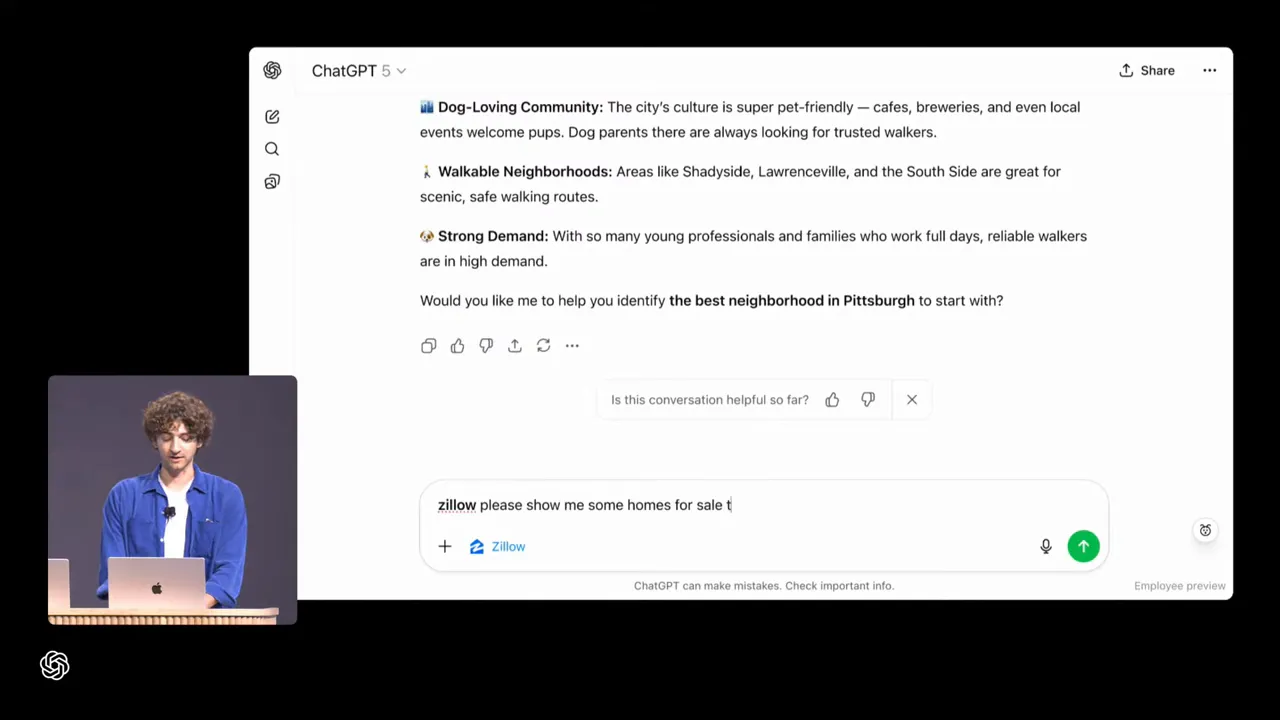

5) Zillow map embedded in ChatGPT(Zillowマップの埋め込みデモ)

解説:外部アプリを会話に引き込み、「会話を操作する」ことでユーザー導線が一段と短くなります。不動産や旅行など“情報を比較して決める”業界で特に強力。

6) Agent Builder canvas(Agent Builderの編集画面)

解説:コードを書かずに流れを可視化できるAgent Builder。私が推すのは「まずは最小構成で稼働させ、Evalsで改善する」ことです。

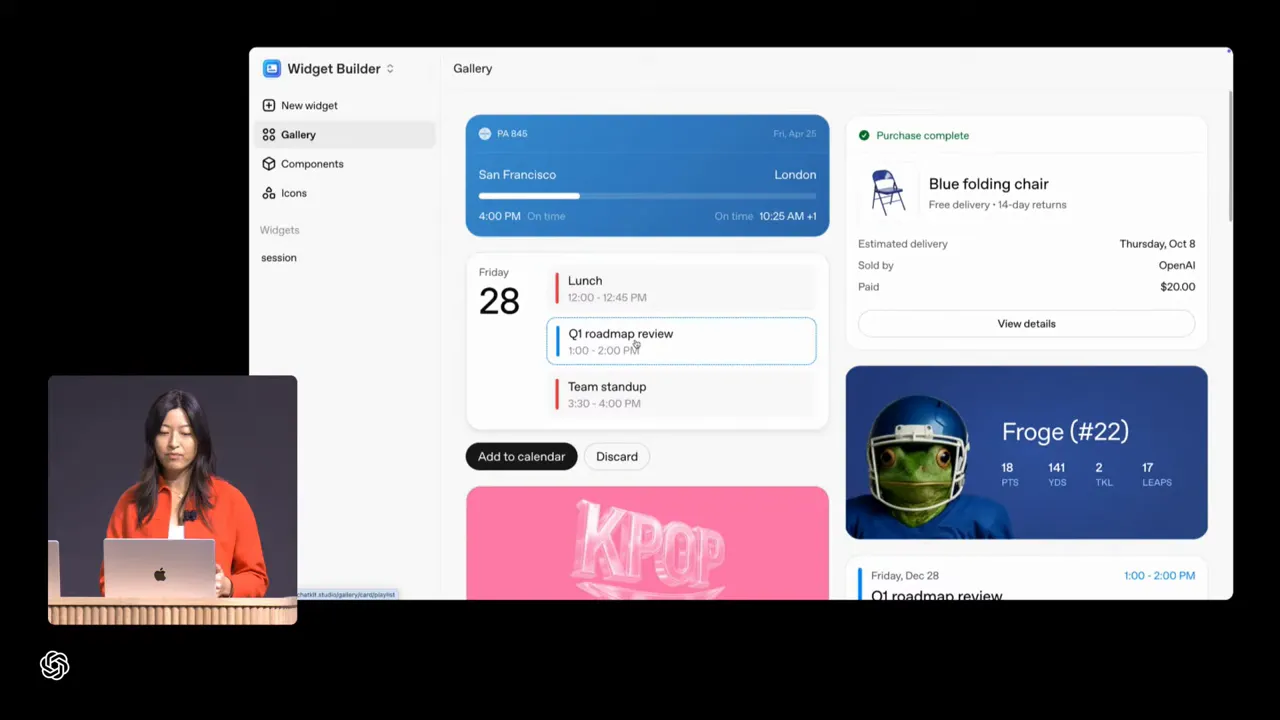

7) Widget builder (Ask Froge)(ウィジェットビルダーの実演)

解説:ウィジェットで視覚的な表示を返せるため回答が一目で分かる。現場負荷が下がるのは大きい。

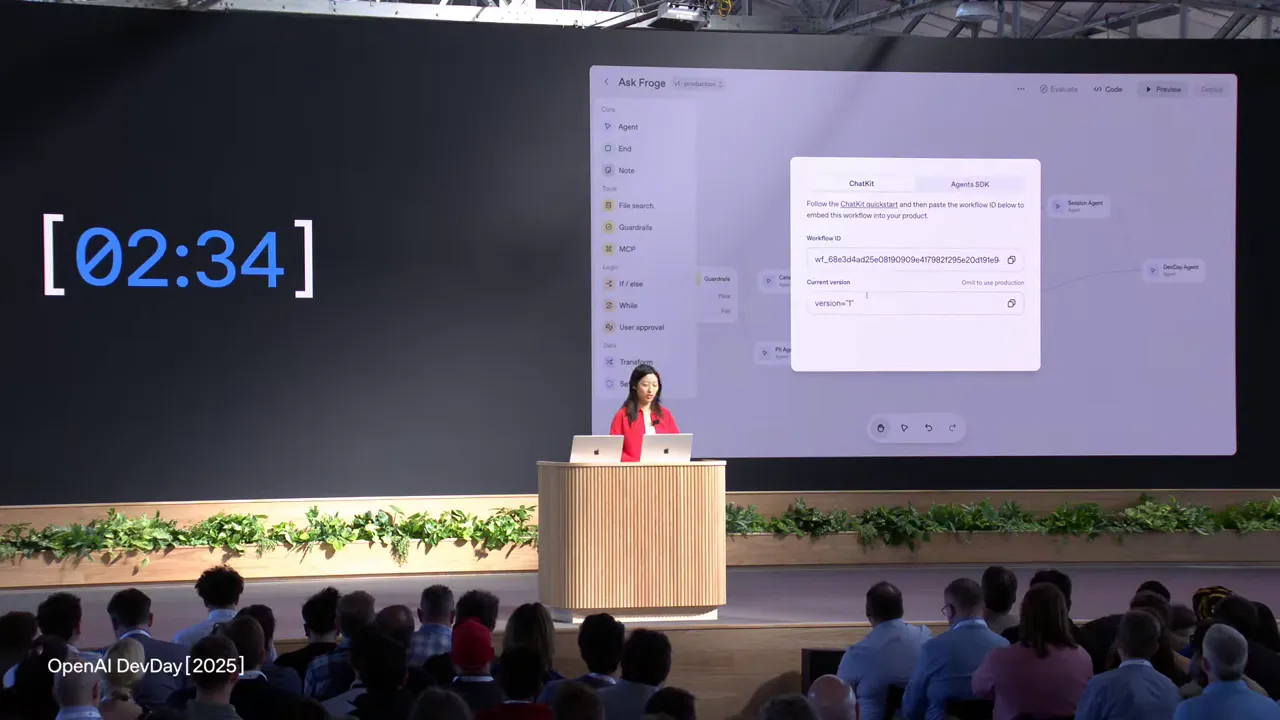

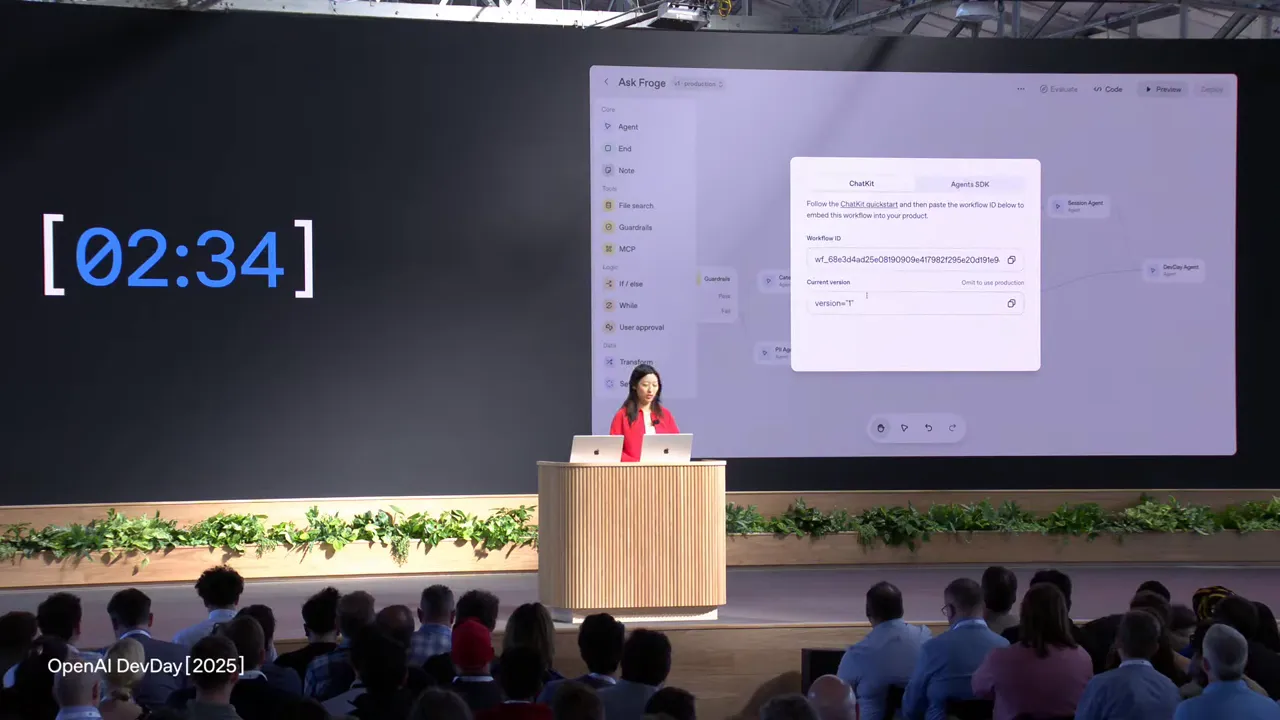

8) Publish workflow & workflow ID(ワークフローの公開とID発行)

解説:コードを書かずに公開 → 埋め込みが可能。これは試作から本番への摩擦が極端に下がる瞬間です。

これ、めちゃくちゃすごいことなんですよ。従来なら、企画担当者が考えたフローをエンジニアがコードに書き起こし、サーバーにデプロイして、やっと埋め込み用のIDやコードが発行されました。この間には何度もやり取りが発生し、数日かかることもザラでした。でもAgent Kitを使えば、企画担当者自身がGUIでエージェントを組み上げ、「公開」ボタンを押すだけ。即座に発行されたIDをWebサイトにペタッと貼れば、もう本番で動いてしまう。アイデアを思いついてから、ユーザーが使えるようになるまでの時間が、数日から数分に短縮される。この“摩擦の低下”が、ビジネスのスピードを根底から変えるんです。

9) Codex intro and control panel(Codexの紹介とコントロールパネルデモ)

解説:CodexはUI・バックエンド・外部機器の結合を自動化できる“仕事仲間”。ここからの革新は大きいです。

デモでは、カメラや照明という「物理的なモノ」を、Web UIから操作するアプリを作りましたよね。普通なら、UIを作る人(フロントエンド)、サーバーの処理を書く人(バックエンド)、そしてカメラの特殊な制御方法を調べる人(ハードウェア担当)がチームを組んで、仕様書を元に連携しながら開発します。Codexは、この複数人の役割を一人でこなしてしまう「スーパーフルスタックエンジニア」みたいな存在。「こういうUIで、このカメラを動かしたい」という自然な言葉での指示を理解し、UIのコード、サーバーのコード、そしてカメラを動かすための特殊な命令まで、全部自動で書き上げてしまう。これは単なるコード生成AIではなく、システム全体の設計と実装を自律的に行う“共同開発者”への進化を意味します。

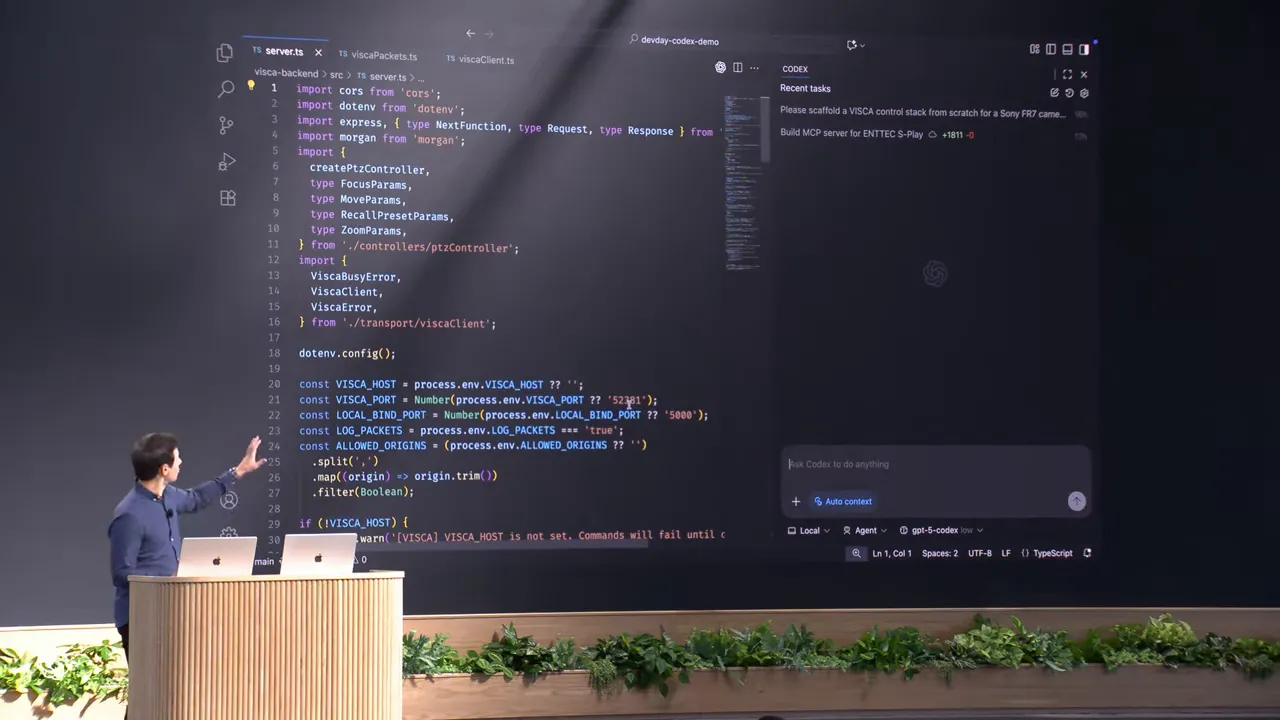

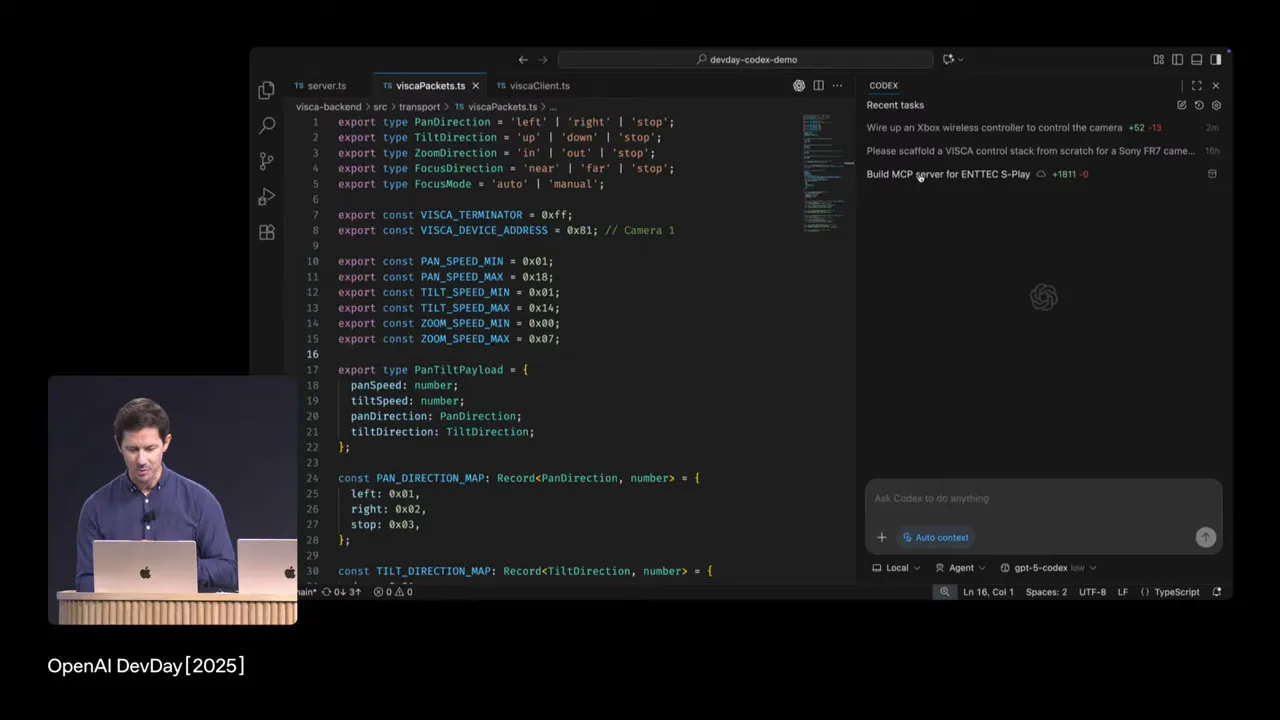

10) Codex files in VS Code(Codexが生成したファイルをVS Codeで表示)

解説:30年ものプロトコルも、Codexにかかれば短時間で動くコードになります。学習コストが一気に下がりますよね。

デモで出てきた「Viscaプロトコル」は、業務用カメラを制御するための30年以上前の技術仕様です。今どきのエンジニアはまず知りません。普通なら、開発者はまず分厚い英語の仕様書を探し出し、何日もかけて解読し、試行錯誤しながらコードを書く必要がありました。これは膨大な「学習コスト」です。しかし、Codexはインターネット上の膨大な技術文書を学習済みなので、まるで「30年の経験を持つベテラン技術者」のように、古いプロトコルの知識も持っています。だから「このプロトコルでカメラを動かして」と頼むだけで、一瞬で動くコードを生成できる。エンジニアはもう、ニッチな技術の学習に時間を費やす必要がなくなり、本当に作りたいものの本質的な部分に集中できるんです。

11) Applying cloud task locally(クラウドタスクをローカル環境に適用)

解説:クラウドで生成された変更をローカルに落とし込んでテスト可能。CI/CDに組み込みやすいですね。

これは現代的な開発スタイルに非常にマッチしています。「クラウドでタスクを実行」とは、複雑で時間のかかるコード生成処理を、OpenAIの強力なサーバーに丸投げすることです。その間、自分のPC(ローカル環境)は他の作業ができます。そして処理が終わると、Codexが「こんな変更をしたよ」という差分だけを送ってくれる。エンジニアは自分の使い慣れたVS Code上で、その変更内容を確認し、「OK、これなら問題ない」と承認して自分のコードに反映(Apply)できる。これは、チーム開発で同僚のコードをレビューするのと同じ流れです。この仕組みは、CI/CD(継続的インテグレーション/継続的デプロイ)、つまりコード変更後に自動でテストや本番反映を行う仕組みと非常に相性が良い。Codexが書いたコードも、人間が書いたコードと同じように、品質管理のパイプラインに乗せられるわけです。

12) Voice agent controlling lights(音声エージェントによる照明制御)

解説:音声対話 → 実世界アクションという体験。イベントやスマートオフィスでの利用価値が高いです。

このデモのすごいところは、「声」という最も自然なインターフェースで、PCの画面内だけでなく「現実世界のモノ」を動かした点です。これは、(1)リアルタイム音声認識、(2)意図理解(「観客を照らして」)、(3)ツール実行(照明システムのAPIを叩く)、(4)音声合成、という複数のAI技術が連携して初めて実現します。例えば、会議室で「OK、AIアシスタント。プレゼンを始めるから、部屋を暗くしてプロジェクターをつけて」と話すだけで準備が整ったり、イベント本番中に「舞台監督AI、BGMをフェードアウトして、次の登壇者のスポットライトをオンに」と指示したり。物理的なコントローラーやPC操作が不要になる未来を具体的に見せてくれました。

13) GPT-5 Pro announcement(GPT-5 Proの発表)

解説:複雑領域での正確性が重要なプロジェクトでは、このモデルが選択肢になります。医療・法務・金融での活用が想定されますね。

GPT-5 Proの価値は、単に賢いだけでなく「信頼性・正確性」が格段に向上した点にあります。例えば、医療分野でAIに論文を要約させる場合、わずかな解釈ミスが命に関わるかもしれません。法務分野で契約書をレビューさせるなら、たった一つの条項の見落としが巨大な訴訟リスクに繋がります。GPT-5 Proは、そうした専門的で複雑な文書のニュアンスをより深く理解し、論理的な矛盾や事実誤認(ハルシネーション)を極限まで減らすように設計されています。趣味のチャットボットなら多少の間違いは許されますが、企業の基幹業務や専門家の意思決定を支援するツールには、このレベルの正確性が不可欠なんです。

14) Sora 2 video generation preview(Sora 2によるビデオ生成プレビュー)

解説:映像制作フローのスピードが数倍になります。デザインチームの試作回数を爆増させるツール。

従来の映像制作は、企画→絵コンテ→撮影→編集→音響効果…と、多くの専門家が関わる時間とコストのかかるプロセスでした。特に広告映像などは、A案とB案を比較したくても、両方撮影するのは大変です。Sora 2は、この「絵コンテから動く映像+音」までの工程を、テキスト指示だけで一気に飛び越えてしまいます。マーケターが「柴犬が宇宙を散歩する、レトロフューチャーなCM動画」と書けば、数分後には複数のパターンの映像が完成する。これにより、本格的な撮影に入る前に、大量のアイデアを「動くプロトタイプ」として試し、最も効果的な案をデータに基づいて選べるようになります。まさに試作(プロトタイピング)の革命ですよね。

15) Mattel toy concept demo(Mattel社による玩具コンセプト実演)

解説:実際の企業がPoCで使っている事実は信頼の裏打ち。プロダクト設計の初動で効果が出る好例です。

Mattel(マテル)のような世界的な玩具メーカーがデモに登場したことの意義は大きいです。これはSora 2が単なる「面白いおもちゃ」ではなく、「実際のビジネスで価値を生むツール」であることを証明しています。玩具開発では、デザイナーのスケッチから実際に金型を作って試作品(プロトタイプ)を作るまでに、莫大な時間と費用がかかります。しかしSora 2を使えば、スケッチを元に「このおもちゃが実際に動いたら、どんな風に楽しく見えるか」というコンセプト動画を瞬時に作成できる。これを使って、企画会議でプレゼンしたり、子どもたちに意見を聞いたりすることで、本格的な製造に入る前に「本当にこの商品は売れるのか?」という最も重要な問いの答えを得やすくなります。これは、製品開発の初期段階(コンセプト設計)におけるリスクを大幅に下げる、非常に賢い使い方です。

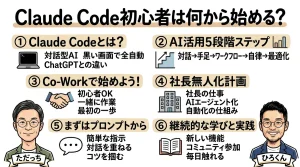

実践ロードマップ:ひろくん流「最短でAIの価値を引き出す」5ステップ

現場目線で言うと、全部いきなりやる必要はありません。優先順位をつけて段階的に導入するのが最短で価値を出す方法です。私がコンサルで推す順番は以下:

- スモールプロトタイプ(1週間)

目的:顧客の頻出質問や操作フローをAgentに代替させ、効果を定量化する。

アクション:Agent Builderで1つのWorkflowを作り、ChatKitをページに埋める(Ask Frogeモデル)。 - 評価とEvalsの整備(2週間)

目的:レスポンスの合否判定・トレースグレードを用意し、安全性と品質を担保。

アクション:主要FAQセットをテストケース化、ガードレール導入(PIIブロック、モデレーション)。 - Codex導入(並行・1ヶ月)

目的:開発スピードの加速とSA(システムアーキテクト)の生産性向上。

アクション:小さなリファクタリングやテンプレート生成から始め、次第に自動化タスクを増やす。 - Sora 2のクリエイティブ適用(1〜2ヶ月)

目的:マーケティングやプロダクト概念を高速検証。

アクション:既存の広告クリエイティブをSora 2で複数案生成してKPI比較。 - スケールとモネタイズ(継続)

目的:Apps SDKやAgentic commerceを活用した収益化。

アクション:サブスクリプション・決済フローを整備、パートナーアプリとして公開申請。

この順序は「まず価値を出し、次に品質と安全を固め、そしてスケールする」という原理に基づいています。私がこれまで手がけた複数の事業でも、このパターンで成果が出ていますよ。

開発者向け実装チェックリスト:安全なAI導入のために

- APIキー運用のポリシーを作る(ローテーション、IP制限、権限管理)。

- ログと監査(誰がいつどのAgentを呼んだか)を取る仕組みを必ず準備。

- ガードレール(PII、危険行為、金銭トランザクション)は最初から入れる。

- ユーザー向けに「この回答はAIによる」表示を行い、透明性を確保。

- Evalsを導入してA/Bテストを常時回す文化をつくる。

- モデル切り替え(GPT-5 Proなど)のコストと応答時間の評価を行う。

ひろくんのワンポイント戦術:AI活用の効果を最大化する4つのコツ

私がクライアントで実践して効果が出た戦術を共有します。

- 「可視化+会話」を組み合わせる

単なるテキスト回答ではなくウィジェットやグラフを返すとユーザーの意思決定が速くなる。特にアナログな現場やデータに溺れがちなEコマースで有効。 - 初期は“人間 in the loop”を残す

自動化を急ぐと誤動作リスクがある。重要な判断は人間の承認があるワークフローを残すだけで現場はずっと安心して導入できます。 - APIを日常ツールに繋ぎ込む

Sora 2のような強力なAPIは、専用アプリから使うだけではもったいないです。LINEやChatwork、Slackなど、チームが毎日使っているツールに連携させることで真価を発揮します。例えば「今日のランチ動画」と写真とチャットを送るだけで動画が返ってくる、そしてMEOやSNSに投稿する仕組みを作れば、動画作成は特別な作業ではなく、日常のコミュニケーションの一部になりますよね。

総括:なぜ「今、動く」ことに価値があるのか

OpenAIのDevDay 2025は「ツールが揃った瞬間」を示したイベントだと私(ひろくん)は受け止めています。Apps SDKでユーザーの会話の中心に入り込み、Agent Kitで業務を自動化・信頼化し、Codexで開発生産性を爆増させ、Sora 2でクリエイティブを爆速にする──これらを組み合わせれば、従来は数ヶ月〜数年かかった価値創出が数日〜数週間で回るようになりますよね。

最後に、私からの個人的な提言:

- まずは1つ、現場の“面倒なタスク”を洗い出して整理整頓してみよう。(自動化はそのあと)

- 安全と透明性を最優先に。信頼がなければ導入は続きません。

- 失敗は早めに小さく。失敗は宝です(私の信条ですよね)。

もしあなたが「どう始めたらいいかわからない」と思ったら、気軽にコメントしてくださいね。一緒に“あなたが頑張らなくても回る仕組み”を作りましょう!

読んでくれてありがとう。今日のデモはたくさんのヒントが詰まっているので、タイムスタンプ付きのキャプチャから気になる箇所へジャンプして、まずは1つ試してみてくださいね。ワクワクしながら次のプロダクトを作りましょう — ひろくんより😊

公式情報リンク集

記事中で紹介した公式情報へのリンクです。ぜひブックマークして、開発の参考にしてください。

- 全般

- 製品・SDK

GPTs研究会はこちら! |

|

無料!AI最新情報コミュニティ |

| 今すぐGPTs研究会をチェック! |

“`